| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | ||||||

| 2 | 3 | 4 | 5 | 6 | 7 | 8 |

| 9 | 10 | 11 | 12 | 13 | 14 | 15 |

| 16 | 17 | 18 | 19 | 20 | 21 | 22 |

| 23 | 24 | 25 | 26 | 27 | 28 | 29 |

| 30 |

- 링글커리어

- CommunicateWiththeWorld

- #Ringle

- 스몰토크

- 링글경험담

- #링글

- 영어회화

- 소통챌린지

- 해외취업컨퍼런스

- 영어로전세계와소통하기

- 오피스밋업

- #영어발음교정

- 링글리뷰

- 총각네장어

- 영어공부법

- 뉴노멀챌린지

- 둔촌역장어

- #영어공부

- 링글

- #nlp

- Ringle

- 강동구장어맛집

- 영어시험

- 장어랑고기같이

- #직장인영어

- #링글후기

- 영어공부

- #체험수업

- 화상영어

- 성내동장어

- Today

- Total

Soohyun’s Machine-learning

A Survey of NLP-Related Crowdsourcing HITs: what works and what does not 본문

A Survey of NLP-Related Crowdsourcing HITs: what works and what does not

Alex_Rose 2021. 11. 28. 21:24Amazon Mechanical Turk (AMT) 워커들의 업무 효율과 결과물에 대해서 크라우드소싱 리퀘스터들은 의문과 불안함을 갖고 있다. 너무 다양한 워커들이 있고, 그 워커들의 결과물이 리퀘스터가 원했던 것과 많이 달랐기 때문인데...

이 문제점들을 파헤쳐보고자 한다.

HIT : Human Intelligence Task

2. Background

2.1 워커 비용 지급

AMT에서의 워커들의 평균 급여는 1시간에 3.13 달러 정도인데, 리퀘스터는 보통 시간 당 11.58 달러의 비용을 지불한다. 이렇게 차이나는 이유는 대부분의 HITs가 낮은 비용을 주기 때문이다. (이 논문을 쓴) 연구자들은 AMT 워커들이 조금만 일하고자 했고, 보상의 크기는 데이터 퀄리티에 별 영향을 주지 못했을거라 믿었다.

실제로 잘하는 워커들은 더 나은 보상을 주는 HIT를 항상 선택했다. 그런데 달(month)의 마지막이거나 임대료를 내야할 경우, 워커들은 닥치는대로 일을 하도록 강요받았기에, 때문에 설명서를 읽을 시간이나 실제로 업무를 진행할 시간이 부족했을 수도 있다.

2.2 커뮤니케이션

좋은 커뮤니케이션은 리퀘스터에게는 문제점을 빨리 발견하게 하고, 리퀘스터가 바라는 것을 워커들이 잘 알게 한다.

2.3 Rejections

해당 작업을 거부하는 건 리퀘스터도 워커에게도 문제. 리퀘스터가 작업물을 퇴짜놓게 되면 HIT를 re-publish해야하고 업무 지연이 생길 수 있다. 워커에겐 평판이 상하는 문제나 좋은 월급을 받는 HITs를 하기 위한 approval percentage에 미치지 못할 수도 있기 때문이다.

이 rejections가 적은 양이라 하더라도, 워커는 분명히 시간을 들인 작업이며, 리퀘스터가 보기에 작업물은 그냥 로봇이 한 것을 거절한 것처럼 느끼고 있을 수도 있다. 그래소 이 봇들을 만든 사람들은 리퀘스터 평판을 깎아내리기 위해, 리뷰를 쓰기 시작했다. AMT는 특정 워커가 봇이라는 확신이 들면, 수당은 지급하되 동시에 AMT에다가도 리포팅을 하도록 권장하고 있다.

작업물의 결과에 영향을 끼치는 다른 요인들은, 작업 설명서가 엉망이거나 평가를 위한 표준 기준이 없거나, HITs가 동작하지 않거나 등이다. 앞서 말한 워커포럼들과 웹사이트들은 전체 워커 중 60% 정도가 사용되고 있으므로, 워커 피드백에 주의를 기울여야 한다.

3 접근법

리퀘스터로부터 발생하는 데이터 퀄리티에 영향을 끼치는 미스커뮤니케이션이나 잘못된 이해들을 증명하기 위해, 논문의 저자 중 한 명은 워커로 등록하고, HITs를 검토했다.

이 스터디에는 두 파트가 있는데, 주어진 기간 동안 할 수 있는 모든 AMT HITs의 정보들을 레코딩하는 것과 TurkerView 웹사이트의 정보들, HITs와 리퀘스터들의 리뷰를 레코딩하는 것이다.

3.1 AMT

이 작업은 2021년 8월 25일부터 8월 31까지 이루어졌다. 이 기간 동안 EST(뉴욕)기준 오후 12시에 HITs 페이지를 재로딩하고, NLP 또는 Speech-related (컴퓨터 비전이나 서베이, information retrieval 등은 비포함)관련 HIT들을 아래처럼 레코딩했다.

- HIT 명칭

- 리퀘스터 이름

- 요구되는 qualifications

- 대금 (payment)

- HIT이 올라온 시간

HIT는 3개의 카테고리로 나뉜다.

- NOQUAL : 신규 워커였던 첫번째 저자는 요구조건 만족도 안되었고, 프리뷰도 할 수 없었다

- PREVIEW : 요구조건 만족은 못했지만, 프리뷰는 할 수 있었다

- QUAL : 요구조건 만족이 되었음

프리뷰할 수 있는 HIT라면 공부할 수 있지만 submit은 할 수 없었다. 가능했던 PREVIEW와 QUAL에 한해, 아래와 같은 요소들도 레코딩되었다

테크니컬 이슈들

- Inaccessible : 접속할 수 없고, 볼 수도 없음

- Preview : 적합하게 프리뷰할 수 없었으나, 허용된 워커들에 한해 동작했을 것

- Critical : 작업을 하려고 accept를 했으나 올바르게 동작하지 않음

작업 설명 이슈들

- 완전히 불명확함 : 설명이 이해가 잘 되지 않음. Tasks에 문법에러가 있거나 함

- 불완전함 : 제공된 설명이나 예시가 전체를 커버하지 못함

- 불확실/애매함 : 설명이나 예시가 불확실하고, 다른 형태로 해석될 요지가 있음

- 관련없음 : 설명이나 예시나 HIT를 완료하는데에 도움되지 않음.

다른 코멘트들

3.2 TurkerView

터커뷰는 리퀘스터와 그들의 HIT에 관해 워커들의 관점을 반영한다. 터커뷰에서 레코딩한 것들은 아래와 같다

HIT 보수에 대한 워커 평가

- Generous : 많이 줌

- Well : 꽤 좋음

- Fair : 괜찮음

- Poor : 좀 짜다

- Very Badly : 너무 적음

HIT에 대한 워커들의 (기록된) 평균 보수 (평균 보수 / 평균 시간)

리퀘스터들 보수에 대한 워커 평가

- Generous

- Well

- Fair

- Poor

- Very Badly

리퀘스터에 대한 (기록된) 워커 평균 보수

커뮤니케이션

- poor : 별로

- ok : 괜찮음

- good : 좋음

빠르게 응답하는가 (Approves Quickly)

- slowly : 느림

- average : 평균

- quickly : 빠름

(작업) Rejections

Blocks

4 결과물

4.1 스터디 전반

3개 카테고리(NOQUAL, PREVIEW와 QUAL)의, 총 161개의 HITs를 했다. 몇몇개의 HITs는 같은 거지만 다른 날에, 다른 보수로 릴리즈되었었다. 만약 이름까지 같다면 duplicates로 넣었다.

총 102개의 고유한 HITs가 있고, 79의 다른 리퀘스터들로부터 포스팅되었다. PREVIEW와 QUAL을 보면 56개의 Unique (고유한) HITs가 있는 걸 볼 수 있는데, 이 논문의 나머지는 얘네들로부터 쓰여졌다. (저자가 new worker여서 NOQUAL은 접근을 못했음)

4.2 이슈들

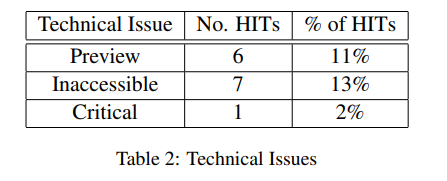

아래에서 보듯이 14번의 테크니컬 이슈가 있었다.

작업 설명서를 떠올려 볼 때, 몇몇 HITs는 불명확한 설명이 있었고, 12개의 HITs는 불완전한 설명이었다. 워커들이 작업을 하기에 어려웠을 것으로 보이며, 관련이 없거나 애매한 설명들 역시 같은 결과를 빚었다. 총 HITs의 27%인 15개의 HITs가 그러했고, 테크니컬 또는 작업 설명서 이슈가 있었던 HITs는 30%에 달하는 17개의 HITs였다. (한개는 테크니컬과 설명서 이슈 모두 있었다)

4.3 HIT 당 보수

아래 테이블4는 TurkerView의 워커 피드백에 기초하여 본, HITs가 지급한 시간당 평균 달러 액수이다. 102개의 최근 HITs 중 54개에 대한 내용이다. 워커가 받은 금액을 HIT를 하는데 쓴 시간에 맞춰 나눈 것이다. 44%에 달하는 24개의 HITs가 시간당 7.25달러보다 낮은 금액을 지급했으며, US Federal의 최저 시급보다 낮은 금액이다. 17%인 9은 7.25와 10달러 사이를 받았고, 39%인 21명이 10달러보다 낮은 시급을 받았다.

이 중에서 17명은 15이상의 시급을 받았다.

4.4 리퀘스터에 대한 워커들의 총 뷰

HIT의 리퀘스터를 워커들이 리뷰할 수 있었다. 아래 테이블은 총 79 중, 67명의 리퀘스터들의 보수 평가에 대한 워커들의 리뷰이다. 43명의 리퀘스터들이 괜찮음(fairly, well, generously) 이상의 평가를 받았고, 나머지는 짜거나 너무 적게 준다는 평가를 받았다.

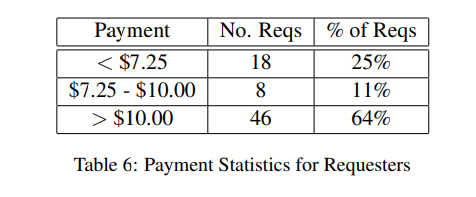

아래는 HITs에서 72명의 리퀘스터가 시간 당 지불한 평균 보수이다. 36%의 리퀫터가 시간당 10달러가 넘는 보수를 지불하는 것에 반대하는 걸 알 수 있다.

19명의 리퀘스터에 대해 커뮤니케이션 스코어를 매긴 아래 테이블을 보면, 26%의 리퀘스터가 커뮤니케이션이 원활하지 못한 것으로 나타났다.

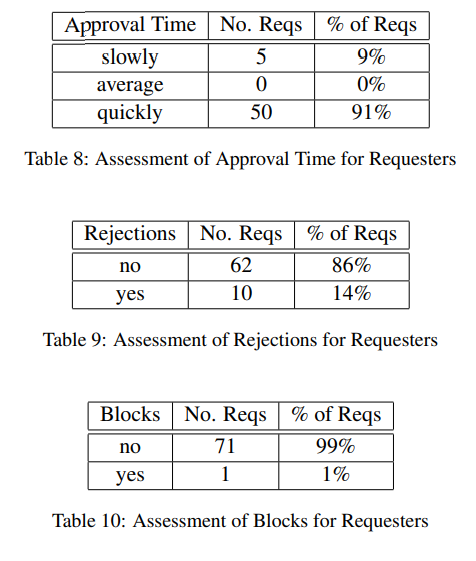

아래 각각은 approval time과 rejections, 그리고 blocking worker 각각에 대해 리퀘스터들을 rating한 것이다.

5 Discussion

5.1 HITs

리퀘스터가 본인이 원한 결과물을 얻는 것에, 테크니컬과 작업 설명서 이슈가 크게 작용했다. inaccessible과 critical 이슈들도 워커들이 HIT을 완료하는 걸 어렵게 했다. 불완전한 설명서는 예기치 못한 형태로 작업을 끝내게 했는데, 모든 HIT 중 30%가 여기에 해당되었다.

5.2 리퀘스터들

워커들의 리뷰에서 나타난 주된 이슈는 보수였다. 리퀘스터들이 지급한 보수 분포는 고른 편이지만, 40%에 달하는 리퀘스터들이 워커들이 괜찮다고 생각하는 수준의 보수를 지급하지 않았다. 64%의 리퀘스터들이 시간당 10달러 이상의 금액을 지불하는 동안, 할 수 있는 HITs 대다수가 이보다 낮은 보수를 지급한다.

또한 워커들은 72 리퀘스터 중 10명으로부터 rejections을 경험했다. 이 중 3명은 2%보다 낮은 비율을 보였지만, 4명의 리퀘스터는 25%를 넘는 rejections를 보였다. 이는 워커들이 리퀘스터와 함께 일할지를 결정하는데에 경종을 울린다.

5.3 Qualifications

AMT에서 리퀘스터는 다양한 형태의 qualifications 중 선택할 수 있다. 리퀘스터는 워커가 작업을 500 또는 1000 이상한 사람으로 제한할 수도, qualification 테스트를 하도록 제한하거나, 특정 워커만 하게 할 수도 있다. 이런 엄격함이 덜해보이는 태스크들을 선택했음에도, 여전히 위에서 말한 qualifications 중 하나를 자주 썼다. 그 결과, 저자는 high approval rating만을 사용하는 것이거나 위치 기반의 qualification 등을 사용하는 것만을 할 수 있었다.

5.4 Caveats (주의사항)

몇몇 변수들은 통계에 편향을 일으킬 수 있었다.

- Accessibility of the HIT (접근성)

- Availability of the HIT (가능한지 아닌지)

- 리퀘스터의 리뷰

5.4.1 Accessibility

HIT는 NOQUAL, PREVIEW, 그리고 QUAL의 3개 카테고리로 나눌 수 있다. (accessibility의 한계로 인해) 여기에서 세부적으로 언급된 애들은 PREVIEW와 QUAL HITs에서만 얻을 수 있었다.

5.4.2 Availability

몇몇 HITs는 워커들(봇이나 웹스크레이퍼일 수도 있는)에 의해 빠르게 선점되어서 할 수가 없었다. 또한 몇몇 리퀘스터들은 해당 qualifications를 충족하지 않은 워커들에게는 안 보이게 했을 수도 있다. (그래서 스터디를 진행할 수 없었다)

5.4.3 TurkerView의 리뷰

터커뷰는 HITs의 모든 리퀘스터들에 대한 정보를 갖고 있진 않았다. 새 리퀘스터라거나 리뷰를 할 만큼의 충분한 HITs을 안 해서일 수도 있다.

6 결론

이 논문에서는 워커와 리퀘스터간의 단절이 있다는 걸 알아냈고, 급여가 워커의 눈에도, 연방 급여 표준에도 맞지 많음을 밝혀냈다. 필요한 결과를 얻어내기 위해 HITs의 작업 설명서, 커뮤니케이션, rejections의 이유에 관해서도 리퀘스터의 노력이 필요하다는 걸 알게 되었다.

'Machine Learning > Natural Language Processing' 카테고리의 다른 글

| The Annotated Transformer 번역 (2) | 2021.03.26 |

|---|